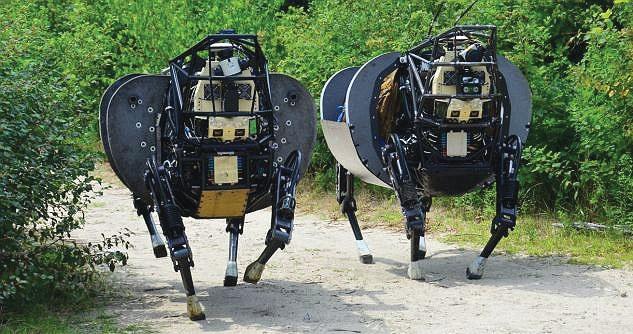

Robot Pembunuh yang Bakal Musnahkan Manusia

Robot pembunuh dapat digagalkan dengan menggunakan teknologi untuk menciptakan lingkungan tak terduga. Namun AS tidak seharusnya mendorong perlombaan senjata robot pembunuh dengan membuat mesin yang lebih besar, lebih cepat, bahkan lebih mematikan.

Pertemuan ke-108 Konferensi Perburuhan Internasional (International Labour Conference/ILC) di Jenewa, Swiss, awal tahun ini membahas tentang Lethal Autonomous Weapons Systems alias robot pembunuh.

Hal itu membuat Liz O'Sullivan, resident technologist untuk Proyek Pengawasan Teknologi Pengawasan, terkejut karena mendengar delegasi AS mengklaim bahwa bahan perang otomatis berteknologi artificial intelligence atau kecerdasan buatan (AI) bisa aman dan dapat diandalkan.

Bukan berarti mereka salah, tetapi menurut Liz, pemikiran mereka membahayakan kita semua. Ini logika yang sama dengan penyebab Perang Dingin, perlombaan senjata nuklir dan Doomsday Clock (Jam Kiamat).

Liz O'Sullivan berhenti dari pekerjaannya pada Januari lalu di sebuah perusahaan teknologi yang menjanjikan. Ia keluar sebagai protes karena khawatir tentang bagaimana Pentagon akan menggunakan AI dalam peperangan dan bagaimana bisnis yang menjadi bagiannya dapat berkontribusi.

Liz telah melihat dari dekat bahaya teknologi yang tidak dapat diandalkan namun kuat ini, dan sejak itu ia bergabung dengan Komite Internasional untuk Kontrol Senjata Robot (ICRAC) dan kampanye untuk menghentikan robot pembunuh dan memastikan bahwa AI digunakan secara bertanggung jawab, bahkan dalam kasus perang. Protes dan keberatannya terhadap persenjataan otonom, membuat ia menghadiri konferensi tersebut sebagai bagian dari delegasi kampanye.

Russia secara aktif berusaha menggagalkan negosiasi internasional untuk mengatur Lethal Autonomous Weapons Systems, dan Tiongkok mengacaukan drone bertenaga AI yang terus meningkat, kekhawatiran potensi penggunaan robot pembunuh kedua negara ini dapat dipahami.

Jika berada di jalur eskalasi sebelumnya, seharusnya bisa lebih pintar kali ini. Mulai saat itu mereka harus menerapkan hukum internasional di bawah penegakan ketat AS yang melarang pengembangan sistem ini dan mengutuk penggunaannya secara global.

Jika tujuannya adalah meredakan ketegangan di seluruh dunia, mereka ingin Russia dan Tiongkok mematuhi larangan tersebut, sehingga dapat mencapai ini dengan membatasi keunggulan militer dari teknologi. Itu juga akan membuatnya kurang menarik bagi lawan untuk mengejar dan kurang sepadan dengan harga yang akan mereka bayar karena berada di luar batas kesepakatan internasional.

Batasan teknis hukum memberikan peluang yang jelas untuk menjaga tutup kotak Pandora ini. Bahkan kita harus mengabdikan pikiran dan sumber daya R&D teknologi tinggi untuk mengembangkan tindakan pencegahan yang kuat daripada yang ofensif. Jika musuh kita membangun Terminator, kita bisa bertarung seperti John Connor, yang dengan gagah berani membela umat manusia dalam pemberontakan melawan para calon penguasa Terminator. ang/R-1

Pengaruhi Keakuratan Model

Sebelum ia meninggalkan pekerjaannya sebagai kepala operasi data di startup teknologi AI, Clarifai, Liz melihat sendiri banyak cara spektakuler dan tak terduga yang bisa membuat AI gagal.

Model AI, menurut definisi, merupakan teknologi prediksi. Mereka hanya dapat memprediksi objek yang sangat mirip dengan objek yang telah mereka lihat sebelumnya, dan tidak mungkin untuk menutupi setiap skenario potensial yang mungkin ditemui model. Sudut kamera, cahaya, kedekatan dengan objek, kualitas kamera dan kondisi cuaca hanyalah beberapa faktor yang mempengaruhi keakuratan model komputer yang mencoba mengidentifikasi targetnya.

Inilah yang peneliti maksud ketika mereka menyebut model seperti itu "rapuh". Mereka cenderung retak ketika dihadapkan dengan skenario yang sedikit berbeda dari kondisi yang diperkenalkan selama konstruksi model. Dapat bermakna ganda ketika berbicara tentang perang, karena kondisi medan jarang dapat diprediksi, dan musuh akan selalu berusaha mencari cara untuk mengeksploitasi kelemahan ini.

Bahkan, ada seluruh bidang penelitian yang didedikasikan untuk membodohi model AI visi komputer - model yang sangat perlu dipasang Pentagon di robot pembunuh sehingga mereka dapat membidik sasaran. Sampai saat ini, tidak ada model visi komputer yang terbukti tahan terhadap eksploitasi yang oleh peneliti yang disebut "serangan permusuhan," sesuatu yang mirip dengan peretasan untuk dengan sengaja membodohi program visi komputer.

Dalam Perang Dunia II, mereka menggunakan sekam (awan tipis dari aluminium) untuk mencegah radar musuh menargetkan pesawatnya. Prinsip yang sama dapat diterapkan pada serangan permusuhan terhadap robot pembunuh.

Dalam kasus analog untuk AI, gambar dengan sedikit "noise" (statis atau gangguan berbasis pixel lainnya) yang ditambahkan ke foto telah terbukti mengalahkan model penglihatan AI - bahkan jika gambar terlihat baik bagi mata manusia. Jadi bayangkan satu peleton tank mengendarai di bawah jaring confetti warna-warni, reflektif atau sesuatu yang sama-sama tidak pada tempatnya. Jika robot belum dilatih untuk menghadapinya, para prajurit di bawahnya praktis tidak akan terlihat. ang/R-1

Luncurkan Serangan Tanpa Manusia

Penelitian menunjukkan bahwa bukan bentuk atau warna tetapi tekstur yang memungkinkan model penglihatan AI untuk mengunci objek tertentu sebelum meluncurkan serangan. Jika Terminator mencari kulit, mari bawa bulu ke pertempuran.

Jika kita ingin menjadi canggih, mari ciptakan kamuflase yang hidup dan dapat berubah menjadi pola dan tekstur generatif. Atau lengkapi pasukan kita dengan benda-benda tak terduga, seperti landak tiup merah muda yang ditempelkan pada kendaraan lapis baja. Sebab benda-benda itu tidak menyerupai apapun yang digunakan untuk melatih algoritma penargetan, karena komputer akan menganggap manusia yang dilihatnya entah bagaimana berbeda dari yang dilatih untuk dibunuh.

Liz tidak mengaku sebagai ahli dalam strategi pertahanan, dan ia senang menyerahkan detail yang tepat kepada John Connors di berbagai laboratorium militer AS. Namun, Liz adalah seseorang yang memiliki akses ke banyak cara model visi komputer yang dapat gagal, baik itu dengan serangan permusuhan atau bahkan hanya bias implisit dari mereka yang berusaha membuatnya.

Klaim delegasi AS tentang kelayakan peperangan di mana mesin dapat meluncurkan serangan tanpa manusia pernah membuat keputusan akhir untuk menarik pelatuk menunjukkan kepada kurangnya keahlian teknis yang diperlukan untuk melakukan percakapan ini dengan sungguh-sungguh. Itu adalah bagian utama dari apa yang membuatnya takut dan orang-orang seperti Liz dengan kampanye menghentikan Robot Pembunuh. Lethal Autonomous Weapons Systems pada dasarnya tidak aman, dan jika kita membiarkan negara - terutama negara yang tidak demokratis - untuk membuat, kita semua akan musnah. ang/R-1

Komentar

()Muat lainnya